La donnée à l'ère du numérique ?

DU GRAIN À L'OUVRAGE À L'ÈRE DU « BIG DATA » APPLICATION À LA CARACTÉRISATION DE SOLS DE SURFACE ET AUX OUVRAGES EN SERVICE

En géotechnique, à l’heure du big data, du machine learning (ML) et de l’intelligence artificielle (IA), les efforts réalisés

pour « maquetter le sol » nécessitent le développement d’appareils de mesure performants et de modèles numériques pour le restituer en 3D ; mais, il est aussi essentiel de mettre en place une architecture claire pour centraliser, stocker, sécuriser, exploiter et modéliser à l’échelle de l’ouvrage les données terrain avec le minimum d’incertitude possible.

Depuis plus de 30 ans, Sol Solution, en collaboration avec l’Institut Pascal et d’autres partenaires universitaires et industriels, consacre d'importants efforts en R&D pour garantir le succès d'un de ses axes de développement stratégique, orienté sur la caractérisation des sols de surface, la numérisation

et l'analyse numérique grâce à une approche big data. L'objectif est de fournir à ses clients des techniques innovantes pour révéler le potentiel du sol tout en favorisant le développement de constructions durables.

DU GRAIN À L’OUVRAGE

Modéliser le sol pour l’introduire dans un BIM est un enjeu séduisant et attractif qui nécessite des investissements importants, sans oublier de lever certains verrous techniques et scientifiques : la prise

en compte de leur nature granulaire discontinue (i) et la variabilité spatiale à l’échelle du terrain (ii).

Quand on parle du sol, il est inévitable de penser à sa nature granulaire et d’imaginer la vraisemblance avec la notion du « big data » : dans une cuillère de sable, on peut compter plusieurs milliers de grains, différents en taille, forme, et qui interagissent entre eux par leurs contacts. Le comportement d'un groupe de grains est intrinsèquement complexe, car les déformations collectives résultant des interactions locales entre eux, sont responsables du comportement mécanique global observé à

une échelle de l'ouvrage. Sous certaines hypothèses, la réponse mécanique du sol dépend uniquement des paramètres physiques des grains (forme, granulométrie…), de leur assemblage (densité, anisotropie…) et de leur interaction avec les fluides. Une faible variation de l’un de ces paramètres peut conduire à une modification importante du comportement à l’échelle macroscopique.

À l’échelle de l’ouvrage, une autre problématique se présente : celle de la variabilité spatiale des propriétés mécaniques des sols.

Dans ce contexte, l’approche du big data offre une occasion unique et une voie de R&D très intéressante pour améliorer les modèles de terrain ; sous réserve de : (a) collecter beaucoup de

données ; (b) constituer des bases de données physiques et numériques ; (c) mettre en place des techniques ML et IA ; et (d) développer des méthodes pour fusionner, spatialiser, probabiliser et modéliser les données. De plus, il est essentiel de mettre en place une architecture informatique solide pour établir une liaison fiable entre les données terrain et les modèles d'ingénierie utilisés dans la conception de projets.

ÉTAPE 1 - DÉVELOPPEMENT D’OUTILS POUR LA CARACTÉRISATION DES SOLS

La caractérisation de sols doit inclure des informations sur le type de matériau présent, son état de compacité et son degré d’homogénéité. Il est donc nécessaire de développer des techniques

simples, basées sur des approches pluridisciplinaires, pour ausculter les sols rapidement, en grand nombre et à faible coût.

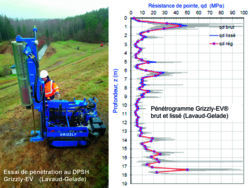

Pour répondre à ce besoin, différents appareils de mesure ont été conçus par Sol Solution et qui répondent à la règle basique des 5 V du big data : volume, véracité, variété, vélocité et valeur. Il s’agit du pénétromètre dynamique instrumenté à énergie variable (Panda, Grizzly-EV, e-Kodiak, Panda 3…) et de la géo-endoscopie. Le grand avantage que le pénétromètre dynamique à énergie variable offre à la démarche big data, est qu'il permet un sondage à haute résolution verticale. La facilité de

répétition des essais sur site permet la mise en oeuvre de méthodes statistiques pour évaluer la variabilité spatiale des propriétés du sol.

La géo-endoscopie a été développée comme un complément à l’essai de pénétration. Sur le terrain, à l’issue d’un sondage, le train de tiges du pénétromètre est retiré et une caméra miniature est insérée, puis glissée jusqu’au fond du trou. Un système d’acquisition numérise les vidéos et la profondeur en continu. Ces informations sont exploitées dans un logiciel dédié intégrant divers algorithmes de traitement d’images, ce qui permet de multiplier les informations visuellement relevées. L’association avec le pénétrogramme permet d'obtenir un « carottage virtuel ».

Le couplage des informations obtenues avec d’autres techniques (forages, CPT, PMT, géophysique…) permet d’agréger d’autres données, ce qui est fondamental dans une démarche big data.

Ces informations doivent être stockées et sécurisées dans une plateforme numérique. Sol Solution a développé une application en ligne, Websprint, multi-équipements, accessible d’un bureau ou d’un chantier, facile à utiliser où toutes ces informations sont sauvegardées, analysées, modélisées et exploitées.

ÉTAPE 2 - CRÉATION DE BASES DE DONNÉES DE SOLS

Pour accompagner le développement des outils de mesure et faciliter la mise en place des phases d’optimisation, d’apprentissage et de validation comprises dans une démarche ML et IA ; la constitution de bases de données est indispensable. Au laboratoire, une BDD physique et numérique d’environ 45 sols différents a été constituée. Pour chaque sol, un échantillon de 2 m3 a été entièrement caractérisé et une grande quantité d’essais a été réalisée (chargement, pénétromètre, géo-endoscope…) en fonction de la densité et de la teneur en eau.

Une BDD in situ a été aussi constituée.

Elle comporte d’une part plus de 5 000 études géotechniques réalisées ; et d’autre part, plus de 100 000 sondages et 10 000 km de mesures géoradar (GPR) obtenus dans le cadre des missions de diagnostic ferroviaire. Récemment, elle a été complétée par celle créée au sein du projet FUI-24 EMeRG3r, associant différents partenaires (université Gustave-Eiffel, laboratoire Navier, Fondasol et Sol Solution). Elle comprend 114 sites, y compris certains historiques, et un total de 1 297 essais.

ÉTAPE 3 - DÉPLOIEMENT DES TECHNIQUES DE ML, D’IA ET DE FUSION DE DONNÉES

Définir les cibles, préparer les données d’entrée, déterminer le bon modèle ; l’entraîner et l’évaluer pour finalement le tester et le déployer sont les étapes fondamentales d’une approche ML. En

fonction du problème abordé et des données d’entrée, les algorithmes utilisés sont divers : réseaux de neurones artificiels, régression logistique, algorithmes génétiques, machines à vecteurs de support… En ce qui concerne la fusion de données, permettant de combiner des données provenant de

sources différentes, on utilise différentes approches qui visent à améliorer la précision des prévisions et réduire les incertitudes associées aux modèles géotechniques en combinant les avantages de différentes sources.

L'application du ML et de l’IA aux données du pénétromètre dynamique, du géo-endoscope, et leur fusion avec des observations géophysiques représente une avancée prometteuse. Dans l’avenir, elle pourrait révolutionner la façon dont nous effectuons la caractérisation des sols de surface.

ÉTAPE 4 - EXPLOITATION : DÉTERMINATION DE LA STRATIGRAPHIE DES SOLS PAR ML & IA

Cette démarche est démontrée au laboratoire.

Les essais pénétrométriques et les images géo-endoscopiques sont analysés, traités et exploités afin d’identifier automatiquement, la stratigraphie, la nature et la consistance des sols. Cette approche est composée de 2 procédés : une méthode d’analyse statistique des signaux pour identifier les différentes couches ; et une méthode d’analyse d’images par apprentissage en vue de faire la reconnaissance automatique.

En laboratoire, les éprouvettes sont composées de 4 types de sols distincts, chacun ayant des épaisseurs, des compacités et des teneurs en eau différentes. Pour chacune des éprouvettes, 3 Panda et 6 géo-endoscopes sont effectués.

Le signal pénétrométrique est analysé en utilisant une méthode par fenêtre glissante, et la stratigraphie est automatiquement déterminée en calculant un coefficient de corrélation intra-classe

et en appliquant un algorithme de détection de pics. La classification de la nature du sol à partir d'images repose sur l'utilisation d'un réseau de neurones profonds pour modéliser le système de

données d'images. On compare les prédictions avec le réel. Du laboratoire à l'analyse, cette approche permet d'automatiser la détermination de la stratigraphie et de la nature d'une colonne de sols. Cependant, cette méthode n'est actuellement utilisée que pour un nombre limité de cas.

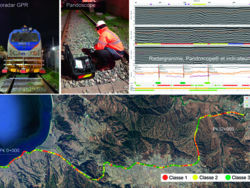

DÉVELOPPEMENT DES INDICATEURS POUR LE DIAGNOSTIC DES ASSISES FERROVIAIRES

Le réseau ferroviaire français s'étend sur plus de 30 000 km, sur lequel chaque jour plus de 15 000 trains circulent. La plupart de ces lignes ont plus de 100 ans et vieillissent en raison de l'usure naturelle des matériaux et des conditions environnementales de plus en plus changeantes, et ceci, malgré un entretien régulier de la part du gestionnaire d’infrastructure. Récemment la France s’est engagée à développer et moderniser le transport ferroviaire afin de répondre aux objectifs de la stratégie nationale bas carbone et de la transition vers les modes de transports décarbonés.

La modernisation du réseau ferroviaire exige des études de diagnostics pour mieux comprendre l'état structurel des couches d'assises, principalement constituées de matériaux granulaires comme le ballast, dans le but d'améliorer leur résistance mécanique.

Pour répondre à ce besoin, Sol Solution a développé une méthodologie novatrice en combinant Panda/géo-endoscope (désormais appelée Pandoscope) et géoradar (GPR). Cette méthodologie

permet une inspection rapide et non destructive des voies. Jusqu'à présent, plus de 10 000 km de mesures GPR et plus de 100 000 Pandoscopes ont été effectués, formant une vaste BDD. Malgré tous ses avantages (rapidité, volume des données…) le GPR a l’inconvénient de l’interprétation et

de son exploitation, qui nécessitent des méthodes d’inversion et d’analyse complexes maîtrisées par des experts.

En conséquence, l'utilisation de l'IA, du ML et de la fusion de données est prometteuse pour interpréter, exploiter et modéliser les données en vue de : caractériser les couches, évaluer le colmatage du ballast et estimer les propriétés mécaniques des sols traversés.

Les signaux GPR sont paramétrisés dans les domaines temporel et fréquentiel, tandis que les données Pandoscope sont utilisées pour établir un paramètre lié à l'état de santé de la couche ballastée. Ces données sont incluses dans la BDD et par la suite les méthodes d'apprentissage, telles que : Kernel Ridge, Support Vector Regression, Linear Regression, Forest Regression, Neuronal-Network et Regression Lasso sont utilisées pour créer un modèle basé sur le GPR permettant d'obtenir le paramètre issu de l’analyse Pandoscope.

Pour choisir le meilleur modèle, on évalue sa performance en un point spécifique de la voie en calculant l'erreur absolue moyenne entre la mesure et la prédiction.

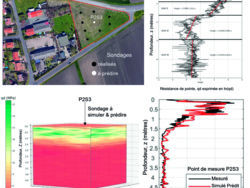

MODÉLISATION PROBABILISTE DE LA VARIABILITÉ SPATIALE DES SOLS DE SURFACE

La variabilité spatiale des propriétés des sols est une source majeure d'incertitude en géotechnique. Les essais sur site étant souvent limités, la description de cette variabilité est subjective. Pour remédier à cela, une approche basée sur l'apprentissage automatique (ML) et l'intelligence artificielle (IA) est proposée pour une évaluation plus objective de la variabilité spatiale du sol.

Cette démarche a été étudiée dans le cadre d'une campagne d’essais menée sur un site à Clermont-Ferrand, où 8 sondages Panda ont été initialement réalisés. La première partie de cette démarche traite de l'identification statistique d'unités de sol homogènes ; la deuxième partie se concentre sur la

modélisation de la variabilité spatiale par le biais de champs aléatoires conditionnels 3D. Enfin, on vise à démontrer la qualité de nos prédictions : on simule un sondage réalisé dans un point donné du terrain et non inclus dans l’apprentissage.

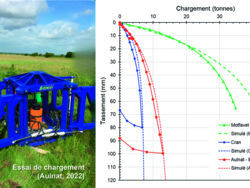

ÉVALUATION DES TASSEMENTS DES FONDATIONS SUPERFICIELLES

L’importance de la donnée pour la caractérisation des sols de surface ne peut être complète sans une mise en pratique. Un cas rencontré au quotidien par le géotechnicien est celui du dimensionnement de fondations superficielles.

En France, la méthode directe basée sur les essais au pressiomètre est couramment utilisée. Elle a été adaptée au pénétromètre CPT. Compte tenu de la qualité de la donnée, de l’inclusion des nouvelles technologies, mais aussi par leur similitude et leur bonne corrélation, on propose de l’étendre au pénétromètre dynamique à énergie variable.

Pour ce faire, la BDD support qui comporte à l’origine 70 essais sous charge verticale centrée a été portée à environ 160 essais, dont une centaine de pénétromètres dynamiques. Elle est complétée

par des essais de chargement réalisés récemment par l’université Gustave-Eiffel et Sol Solution sur des sites de nature différente : sable, argile et limons. Une méthodologie prometteuse est proposée pour exploiter les données du pénétromètre dynamique en vue d'évaluer le tassement d'une fondation soumise à une charge axiale.

On compare les résultats des mesures et les prédictions obtenues pour trois sites tests. Les résultats obtenus montrent l’intérêt de l’approche et mettent en valeur l’importance de la data en géotechnique.

À l’ère du big data et de la diffusion rapide des méthodes d’IA au domaine de la géotechnique, créer et récolter de données en grande quantité à l’échelle du terrain et à moindre coût reste une

étape incontournable. Par la suite, les applications et les opportunités offertes par les approches présentées sont nombreuses.

À ce stade, nous considérons important de citer M. J. Biarez qui, en 1992, déclarait : « Toute mesure “bien faite” in situ est meilleure que rien, donc rien n’est à exclure a priori. Cependant, il faut savoir quelle est l’information qui peut être obtenue sur la loi du comportement du sol… » Cela afin de passer du grain à l’ouvrage.

Miguel Angel Benz Navarrete

Responsable recherche, développement et innovation Sol Solution

Pierre Breul

Directeur, enseignant et chercheur Polytech Clermont, UCA

Philippe Moustan

Responsable commercial Sol Solution

GÉOTECHNIQUE FORAGE FONDATIONS FORAGE D'EAU ESSAIS

M² EXPOSITION INTÉRIEURE

6000

EXPOSANTS

190

M² EXPOSITION EXTÉRIEURE

1 500

PARTICIPANTS

3000